NVIDIA удваивает скорость обучения глубоких нейронных сетей

NVIDIA объявила об обновлении библиотек с алгоритмами глубокого обучения (deep learning) с поддержкой GPU-ускорения. Новая версия ПО позволяет удвоить скорость обучения нейронных сетей. Более точные нейронные сети благодаря ускоренному обучению моделей и их более сложной структуре позволят ученым и исследователям ускорить работу над проектами, связанными с глубоким обучением.

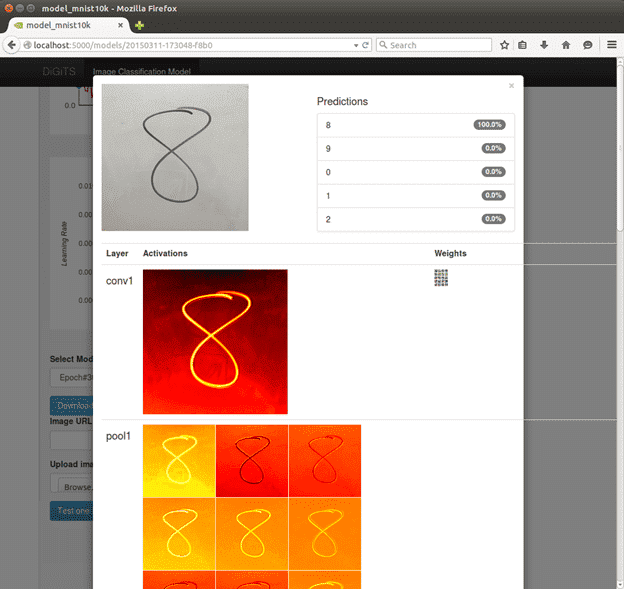

Система глубокого обучения NVIDIA DIGITS™ Deep Learning GPU Training System версии 2 (DIGITS 2) и библиотека NVIDIA CUDA® Deep Neural Network library версии 3 (cuDNN 3) обеспечивают значительно более высокую производительность и предоставляют новые возможности для исследователей. DIGITS 2 теперь позволяет автоматически масштабировать обучение нейронных сетей на несколько высокопроизводительных графических процессоров. Для задач классификации изображений это позволит сократить время обучения сети вдвое (по сравнению с системой на базе одного GPU).

cuDNN 3 позволяет оптимизировать хранение данных в памяти GPU при обучении более сложных нейронных сетей. cuDNN 3 также обеспечивает прирост производительности по сравнению с версией cuDNN 2, позволяя исследователям обучать нейронные сети до двух раз быстрее, чем на системах с одним GPU. Ожидается, что новая библиотека cuDNN 3 будет интегрирована в новые версии фреймворков глубокого обучения Caffe, Minerva, Theano и Torch, которые широко применяются для обучения глубоких нейронных сетей.

“Сегодня высокопроизводительные графические процессоры находятся в основе исследовательских проектов по глубокому обучению и разработке продуктов как в научных организациях, так и в крупных интернет-компаниях, - говорит Ян Бак (Ian Buck), вице-президент по высокопроизводительным вычислениям в NVIDIA. – Мы тесно сотрудничаем со специалистами по обработке данных, разработчиками фреймворков и сообществом глубокого обучения - применяем самые мощные графические решения и меняем представления о возможном”.

DIGITS 2 – обучение становится вдвое быстрее благодаря автоматическому масштабированию на несколько GPU

DIGITS 2 – это первая полнофункциональная система с графическим интерфейсом, которая помогает пользователям проектировать, обучать и тестировать сети глубокого обучения в задачах классификации изображений.

Поддержка автоматического масштабирования на несколько GPU в DIGITS 2 максимально полно задействует ресурсы системы благодаря автоматическому распределению нагрузки между графическими процессорами системы. С помощью DIGITS 2, на системе на базе четырех GPU на базе архитектуры NVIDIA Maxwell™, инженеры NVIDIA обучили широко известную нейронную сеть AlexNet в два раза быстрее, чем на системе на базе одного GPU. 1 И это не предел. Заказчики компании, уже получившие возможность испытать новую версию системы, смогли добиться даже лучших результатов.

«Обучение одной из наших глубоких сетей для автоматического тегирования на одном NVIDIA GeForce GTX Titan X занимает примерно шестнадцать дней. С новой системой автоматического масштабирования при использовании четырех процессоров Titan X процесс сократился до пяти дней, - говорит Саймон Осиндеро (Simon Osindero), архитектор систем искусственного интеллекта для Yahoo Flickr. – Это большое преимущество, оно позволяет нам быстрее получать результаты, а также более масштабно исследовать пространство моделей для получения более точных результатов».

cuDNN 3 – обучение более крупных и сложных моделей становится быстрее

cuDNN – это GPU-ускоренная библиотека математических операций для глубоких нейронных сетей, которую разработчики встраивают во фреймворки машинного обучения высокого уровня.

В cuDNN 3 добавлена поддержка хранения 16-битных данных с плавающей точкой в памяти GPU, что удваивает объем хранимой информации и оптимизирует использование пропускной способности памяти. Благодаря этому исследователи могут обучать более сложные нейронные сети.

«Мы уверены, что поддержка FP16 для хранения данных в памяти GPU в библиотеках NVIDIA позволит нам еще больше масштабировать наши модели, так как это увеличит эффективный объем памяти нашей системы и повысит эффективность масштабирования обучения нейронной сети на несколько графических процессоров, - говорит Брайан Катанзаро (Bryan Catanzaro), старший исследователь в Baidu Research. – В итоге, точность наших моделей возрастет еще больше».

cuDNN 3 также обеспечивает весомый рост производительности в сравнении с cuDNN 2 при обучении нейронных сетей на одном GPU. Так, с новой версией инженеры NVIDIA смогли обучить сеть AlexNet в два раза быстрее на системе на базе одного GPU NVIDIA GeForce® GTX™ TITAN X.2

Доступность

Предфинальная версия DIGITS 2 уже доступна для бесплатного скачивания для зарегистрированных разработчиков NVIDIA. Подробнее смотрите на сайте DIGITS.

Библиотека cuDNN 3 будет доступна в крупных инфраструктурах глубокого обучения в ближайшие месяцы. Подробнее смотрите на сайте cuDNN.

{extravote 5}

AMD и Dell поддерживают изучение биоинформатики в Варшавском университете

Серверные графические процессоры AMD FirePro™ S9150 увеличат производительность систем Центра секвенирования нового поколения (NGSC) в Центре новых технологий Варшавского университета более чем на 1,5 петафлопс. Новые вычислительные возможности понадобятся для исследований в области биоинформатики и секвенирования (NGS). Новый кластер ORION оснащен 150 серверами Dell PowerEdge R730 с двумя графическими процессорами AMD FirePro S9150. Результат – производительность в 1,52 петафлопс одинарной точности и 0,76 петафлопс двойной точности.1 Энергоэффективный кластер позволяет достичь высокой скорости и эффективности вычислений генной информации, что необходимо для целого спектра исследований генома и биоинформатики. Это становится возможным благодаря использованию для исследовательских целей быстрого и высокоэффективного интерфейса программирования OpenCL™.